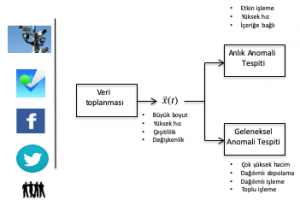

Bilişim ve algılayıcı (sensör) teknolojilerindeki son gelişmeler, mobil ve akıllı cihazların yaygın kullanımı ve Internet sayesinde, veri toplayan sistemlerin kapasiteleri ve yetenekleri son derece artmıştır. Bu yeni bilgi toplama ve bilgiye erişim imkanları sayesinde, günümüzde birçok uygulamada daha önce mümkün olmayan miktarda veri kullanılabilmektedir. Gerçek hayatta karşılaşılan birçok problemin çözümünde, bu büyük hacimdeki verilerin verimli ve soruna odaklı işlenmesinin uygulamalara getireceği kazanç gayet açıktır. Toplanan bu verilerin daha önceki benzer uygulamalarda kullanılan verilere göre karşılaştırılamayacak kadar büyük boyutlarda olması, verilerin hayli çeşitlilik içermesi (video, ses, resim) ve karakteristik özelliklerinin (istatistik, boyut, kalite, gürültü) zaman içinde son derece değişken olması, büyük verilerin Yapay Zeka yaklaşımları ile işlenmesini gerektirmektedir. Çevrimiçi Makine Öğrenmesi yöntemleri, (1) tasarımları gereği, anlık veriyi depolamaya ihtiyaç duymadan sistemi en iyileştirmek için hemen kullandıkları, (2) kendilerini sürekli değişen veri ve problem koşullarına göre uyarladıkları için, büyük veri içeren uygulamaların başarısı için son derece önemli ve gerekli yaklaşımlardır.

Ancak büyük boyutlardaki, yüksek değişkenlik ve çeşitlilik içeren verilerin, geleneksel veri karakteristiklerine ve boyutlarına göre tasarlanmış klasik makine öğrenmesi yöntemlerle işlenmesi, hatta bu geleneksel yaklaşımların gerçek uygulamalarda çalışması, mümkün değildir. Araştırmalarımızda büyük verilerin analizi ve işlenmesi için, (1) büyük verilere özgü Yapay Zeka tekniklerinin ilk defa geliştirilmesi, (2) ortaya çıkarılan yöntemlerin hem pratik hem teorik kazanımlarının matematiksel olarak ispatlanması, ve (3) büyük veri analizi için ilk defa büyük veri Yapay Zeka kuramının ortaya çıkarılmasıdır.

Büyük verilerin Yapay Zeka yaklaşımlarıyla işlenmesindeki en önemli sorun geleneksel yaklaşımların göreceli olarak çok daha küçük boyutlardaki veriler için tasarlanmış olmasıdır. Bunun yanında büyük verilerin küçük parçalar halinde işlenmesine dayanan dağılımlı yöntemler, literatürde sadece en basit ve genelde çevrimiçi olmayan yaklaşımlar için tasarlanabilmiştir. Dağılımlı yöntemlerin büyük veriler için çevrimiçi halleri, yüksek seviyedeki haberleşme gereksinimleri nedeniyle gerçekçi problemlerin çözümlerinde kullanılamamaktadır. Bu doğrultuda, yüksek karmaşıklık içeren ve son derece iyi performans gösteren geleneksel Yapay Zeka yöntemleri kadar iyi performans sağlayacak, ama büyük verilere pratikte uygulanabilir Yapay Zeka teknikleri geliştirilmektedir. Ortaya çıkarılan yaklaşımların verim değerleri ve performans kazançları matematiksel olarak da ispatlanmaktadır.

Örnek Yayınlar

N. D. Vanli and S. S. Kozat, “A Unified Approach to Universal Prediction: Generalized Upper and Lower Bounds,” IEEE Transactions on Neural Networks and Learning Systems, 2013.

N. D. Vanli, M. O. Sayin and S. S. Kozat, “Twice Universal Piecewise Linear Regression via Infinite Depth Context Tree Weighting Method,” IEEE Transactions on Neural Networks and Learning Systems, 2013.

H. Ozkan and S. S. Kozat, “Data Imputation through the Identification of Local Anomalies,” IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013.