Son yıllarda yaşamımızın önemli parçalarını oluşturan sağlık, hukuk ve ulaşım gibi alanlarda hayatımızı etkileyecek kararları almada sıklıkla makine öğrenimine başvurulduğunu biliyoruz. Örneğin, Amerika Birleşik Devletleri’ndeki bazı eyaletlerde adli davalarda hakimler, sanığın yargı sürecinin tutuklu mu tutuksuz mu devam edeceği kararını verirken, sanığın adli geçmişi ile ilgili bilgileri kullanarak yeniden suça karışma riskini tahmin eden bir algoritma kullanmaktadırlar. Teoride çok iyi sonuçlar veren ve düzgün çalıştığı düşünülen makine öğrenimi yöntemlerinin gerçek hayatta kullanılmaları, önceden kestirilmesi zor olan olumsuz sonuçlar doğurabilir. Örneğin, yargı alanında kullanılan ve yukarıda bahsedilen yöntemin, risk tahminini yaparken sanığın etnik köken bilgisini direkt olarak kullanmamasına rağmen siyahlara karşı önyargılı olduğu görülmüştür. Bunun sebeplerinden birinin modelin eğitilmesinde kullanılan verinin azınlıklara karşı önyargılı kararlar içermesi olduğu düşünülmektedir. Bu çalışmada, farklı gruplar için adil kararlar verebilmek için makine öğrenimi algoritmalarının hangi adillik ölçütlülerini gözetmesi gerektiği ve bu adillik ölçütleri kullanıldığı zaman, farklı grupların sistemdeki temsilinin zaman içinde nasıl değişeceği araştırılmıştır. Farklı grupların sistemdeki temsil oranlarını eşitlemek için makine öğreniminde hangi adalet kriterlerinin kullanılması gerektiği saptanmıştır.

Son yıllarda yaşamımızın önemli parçalarını oluşturan sağlık, hukuk ve ulaşım gibi alanlarda hayatımızı etkileyecek kararları almada sıklıkla makine öğrenimine başvurulduğunu biliyoruz. Örneğin, Amerika Birleşik Devletleri’ndeki bazı eyaletlerde adli davalarda hakimler, sanığın yargı sürecinin tutuklu mu tutuksuz mu devam edeceği kararını verirken, sanığın adli geçmişi ile ilgili bilgileri kullanarak yeniden suça karışma riskini tahmin eden bir algoritma kullanmaktadırlar. Teoride çok iyi sonuçlar veren ve düzgün çalıştığı düşünülen makine öğrenimi yöntemlerinin gerçek hayatta kullanılmaları, önceden kestirilmesi zor olan olumsuz sonuçlar doğurabilir. Örneğin, yargı alanında kullanılan ve yukarıda bahsedilen yöntemin, risk tahminini yaparken sanığın etnik köken bilgisini direkt olarak kullanmamasına rağmen siyahlara karşı önyargılı olduğu görülmüştür. Bunun sebeplerinden birinin modelin eğitilmesinde kullanılan verinin azınlıklara karşı önyargılı kararlar içermesi olduğu düşünülmektedir. Bu çalışmada, farklı gruplar için adil kararlar verebilmek için makine öğrenimi algoritmalarının hangi adillik ölçütlülerini gözetmesi gerektiği ve bu adillik ölçütleri kullanıldığı zaman, farklı grupların sistemdeki temsilinin zaman içinde nasıl değişeceği araştırılmıştır. Farklı grupların sistemdeki temsil oranlarını eşitlemek için makine öğreniminde hangi adalet kriterlerinin kullanılması gerektiği saptanmıştır.

Örnek Yayınlar:

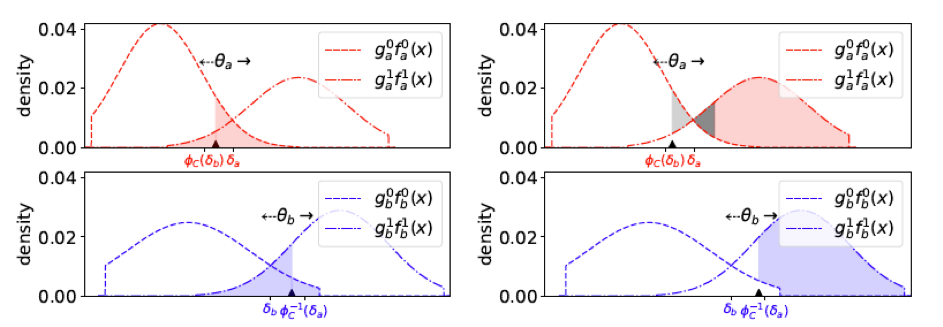

X. Zhang, M. M. Khalili, C. Tekin and M. Liu, ” Group retention when using machine learning in sequential decision making: The interplay between user dynamics and fairness”, in Proc. 33rd Conference on Neural Information Processing Systems (NeurIPS), December 2019.